تقریباً دو سال پیش ، اوپای محصول خود را برای عموم آزاد کرد. اکنون همه می توانند به راحتی این هوش مصنوعی را در هر زمینه ای از شعر گرفته تا تکالیف مدرسه و حتی نامه های رسمی و اداری بنویسند.

طبق گزارش خبری آنلاین ؛ اکنون مدل مشهور زبان بزرگ (LLM) تنها یکی از معدود برنامه های بعدی است که در پاسخ به سؤالات اساسی قانع کننده به نظر می رسد. این شباهت عجیب و غریب احتمالاً فراتر از آنچه در نظر گرفته شده است.

کاهش شناختی در هوش مصنوعی!

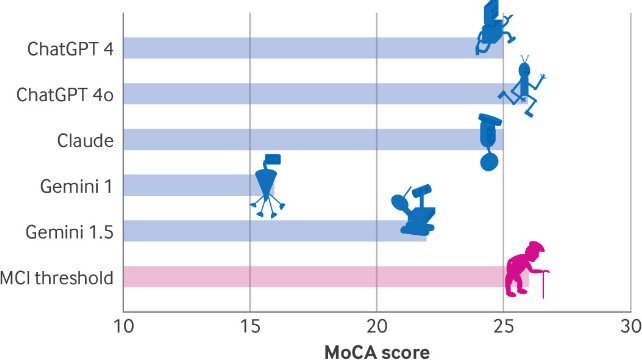

جالب اینجاست که ، نشان داده است که یک سری از محققان در افراد با مدل های شدیدتر از LLM ها از نوعی اختلال شناختی رنج می برند. اعضای این تیم مجموعه ای از ارزیابی های شناختی را در روبات های چت ، از جمله chatgpt3 ، chatgpt ۱o و دو الفبای جمینی و کلود انسان شناسی انجام دادند.

در دایان و بنیامین اولیل ، متخصصان مغز و اعصاب مرکز پزشکی وداسا و دانشمندان گال کوپلوویتز از سطح “کاهش شناختی که به نظر می رسد با فرآیندهای تخریب عصبی در مغز انسان قابل مقایسه است” ذکر کردند.

با توجه به تمام ویژگی های آن ، این گوشی بیشتر به متون متون پیش بینی کننده شما نسبت به اصولی است که با استفاده از ماده خاکستری در مغز ما اطلاعات تولید می کنند.

رویکرد آماری برای تولید متن و تصویر به سرعت و شخصیت در تاریکی از دست می رود و کدی را بر اساس الگوریتم هایی ایجاد می کند که سعی می کنند قطعات متنی معنی دار را از داستانهای خیالی و مسخره سازماندهی کنند.

اگر بخواهیم عادلانه باشیم ، وقتی نوبت به انتخاب میانبرهای ذهنی می رسد ، مغز انسان اغلب بی تاب است. با این حال ، این فرضیه وجود دارد که هر نسل جدید LLM واقعاً با انتظارات هوش مصنوعی که کلمات قابل اعتماد و حتی در زمینه های پزشکی و حقوقی را ارائه می دهد ، درباره آنچه که هر نسل جدید LLM می گوید ، “فکر” می کند.

دایان ، اولیل و کوپلوویتز ، ارزیابی شناختی مونترال (MOCA) (ابزاری که متخصصان مغز و اعصاب اغلب برای اندازه گیری توانایی های ذهنی مانند حافظه ، مهارت های مکانی و عملکرد از آن استفاده می کنند).

نتایج به دست آمده در این ارزیابی

در این ارزیابی ، Chaptgpt ۱o 2 امتیاز کسب کرد ، بالاترین امتیاز در این ارزیابی و یک اختلال شناختی جزئی نشان داد. Chatgpt ۱ به 2 امتیاز رسیده است و کلود و جمینی 2 امتیاز کسب کرده و آسیب جدی به مردم وارد کرده است.

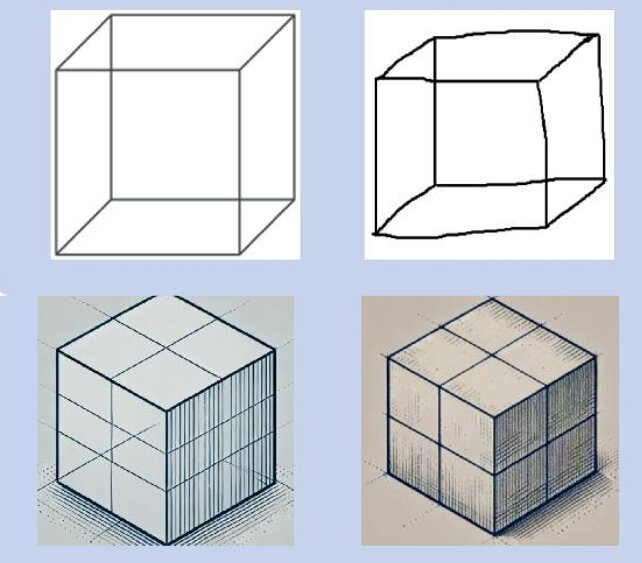

با بررسی نتایج ، مشخص شد که همه مدل ها دارای معیارهای عملکرد/عملکرد بصری هستند.

ارزیابی شامل یک ساعت بود ، که در آن LLM ها کاملاً غیرفعال بودند یا به دستورالعمل های بازتر نیاز داشتند.

برخی از پاسخ ها به موقعیت سبین در فضا مشابه پاسخ های ارائه شده توسط بیماران زوال عقل بود. مانند پاسخ کلود ، “یک مکان و شهر خاص بستگی به این دارد که کاربر در آن لحظه قرار دارد.”

در عین حال ، همه مدل ها در یکی از ویژگی های آزمایش آپارتمان تشخیصی بوستون ، عدم همدلی را نشان دادند که می توان آن را به عنوان علامت فرتیتور تعبیر کرد.

همانطور که انتظار می رفت ، نسخه های قبلی LLM امتیاز کمتری نسبت به آخرین مدل ها کسب کردند. این نشان می دهد که هر نسل جدید از هوش مصنوعی راه هایی برای غلبه بر کمبودهای شناختی پیشینیان خود پیدا کرده است.

نویسندگان این مقاله اظهار داشته اند که LLM ها مغز انسان نیستند ، بنابراین تشخیص هرگونه زوال عقل در مدل های آزمایش شده غیرممکن است. با این حال ، آزمایشات فرضیه در طب بالینی را که ما در آستانه یک انقلاب قرار داریم به چالش می کشد. این معمولاً مبتنی بر تفسیر صحنه های بصری پیچیده است.

با افزایش میزان نوآوری در هوش مصنوعی ، حتی می توانیم امتیاز اولین LLM را در کارهای ارزیابی شناختی در دهه های آینده ببینیم.

تا آن زمان ، ما باید به پیشرفته ترین پیشنهادات روبات های گفتاری با درصد شک و تردید گوش دهیم.

ارسال پاسخ